안녕하세요, 교보DTS 이송이 사원입니다.

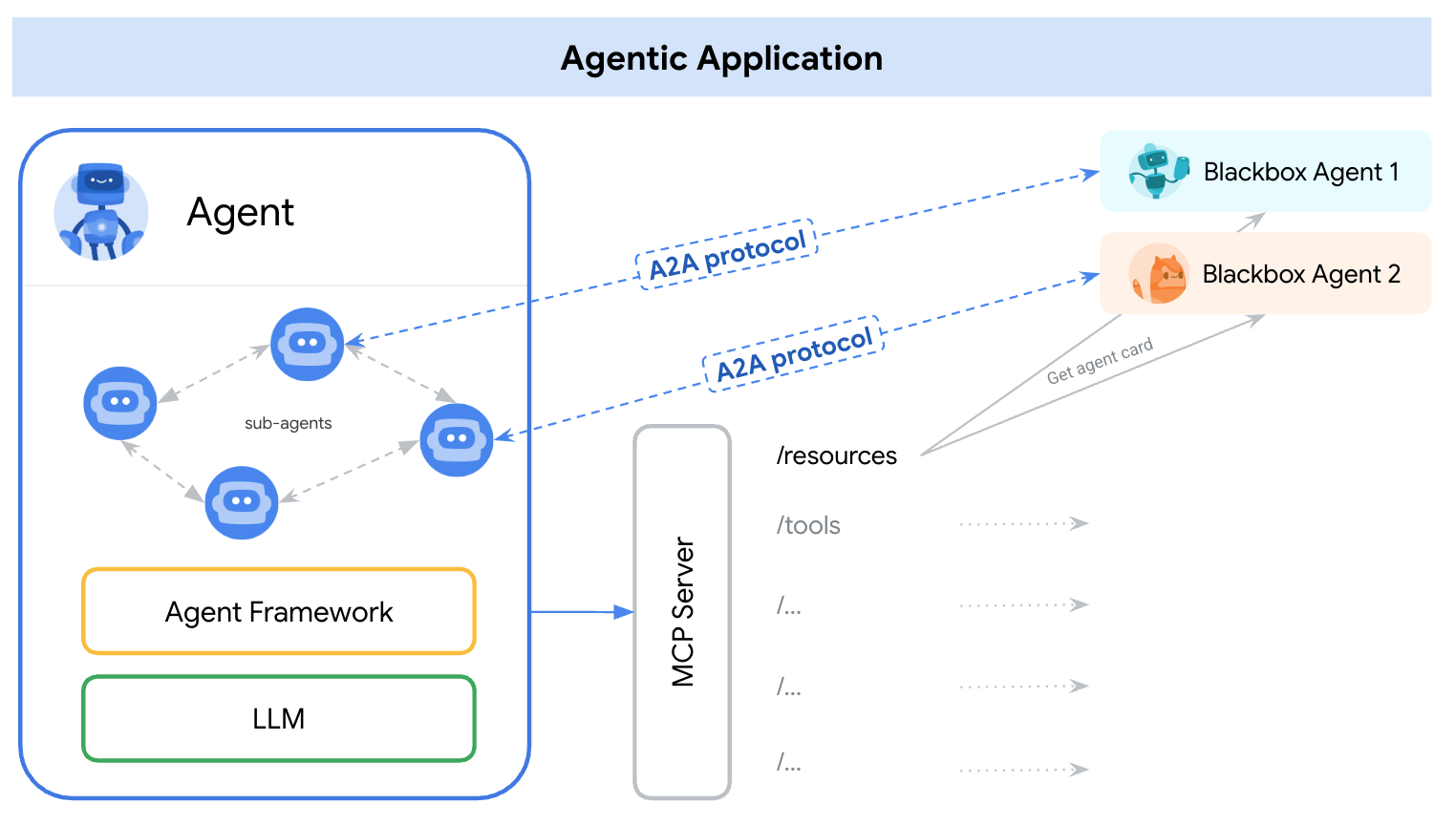

AI는 단일 LLM의 한계를 넘어 여러 에이전트가 협력하여 작업을 수행하는 멀티에이전트 구조로 진화하고 있습니다.

이 변화의 중심에는 두 가지 핵심 프로토콜이 있습니다:

- A2A (Agent-to-Agent): 에이전트 간의 상호작용을 위한 개방형 통신 표준

- MCP (Model Context Protocol): LLM이 외부 시스템과 안전하고 유연하게 연결되도록 돕는 인터페이스 프로토콜

이 글에서는 A2A와 MCP가 각각 AI의 ‘협업’과 ‘도구 연결’을 어떻게 담당하는지 살펴보고, Hands-on 예제를 통해 AI 오케스트레이션의 개념과 구조를 이해합니다.

서론: 생성형 AI의 다음 단계

최근 GPT, Claude, Gemini 등 대규모 언어모델(LLM)의 발전으로 자연어 이해, 문서 생성, 검색, 요약, 번역 등 다양한 작업이 단일 LLM의 질의-응답 구조만으로도 가능해졌습니다. 이로 인해 산업 전반과 일상에서 AI 활용이 폭발적으로 확대되었습니다.

하지만 LLM은 여전히 “단일 모델”이라는 근본적인 한계를 안고 있습니다. 복잡한 업무를 처리하려면 여러 단계와 다양한 전문성이 필요하지만 하나의 LLM이 모든 것을 해결하기에는 구조적 한계가 존재합니다.

예: “오늘 발표된 AI 관련 뉴스를 찾아서 3문장으로 요약해줘.”

- 실시간 뉴스 검색

- 콘텐츠 요약

- 최종 사용자 보고

또한, 긴 대화나 복잡한 문맥에서 이전 정보를 잊거나 잘못 해석하는 경우가 발생하며, 외부 데이터나 도구에 직접 접근하지 못해 실질적인 업무 자동화에는 한계가 있습니다.

이러한 한계를 극복하기 위해 등장한 개념이 바로 멀티 에이전트(Multi-Agent) 협업입니다. 각 기능에 특화된 멀티 에이전트가 각자의 역할을 분담하고 서로 소통하며 복잡한 업무를 단계별로 처리하는 구조입니다. 이 과정에서 에이전트 간 통신의 표준화와 외부 도구와의 연결성이 핵심 과제로 부상했으며, 이에 따라 A2A(Agent-to-Agent)과 MCP(Model Context Protocol)가 주목받고 있습니다.

두 프로토콜은 각각 AI의 ‘협업’과 ‘도구 연결’을 담당하며, 함께 사용될 때 더욱 강력한 멀티에이전트 오케스트레이션 시스템을 실현할 수 있습니다.

이처럼 AI는 단일 모델 중심에서 벗어나, 멀티에이전트 협업과 표준화된 프로토콜 기반의 오케스트레이션으로 진화하고 있습니다.

본론: MCP와 A2A의 관계

1. A2A 프로토콜: 에이전트 협업의 표준

A2A 프로토콜은 구글이 2025년 ‘구글 클라우드 넥스트(Google Cloud Next)’에서 공개한 개방형 통신 프로토콜입니다.

기존에는 여러 AI가 단일 워크플로에 참여하더라도 API 호출이나 연동에 의존해 협업이 제한적이었으나, A2A는 서로 다른 에이전트 간 상호작용이 가능하도록 표준 언어와 구조를 제공해 효율적인 오케스트레이션을 실현하는 핵심 인프라입니다.

- 에이전트 간 역할 분담: 검색, 요약, 분석 등 전문 에이전트가 작업을 분담

- 메시지 기반 협업: JSON 형식의 메시지를 주고받으며 상태, 요청, 응답을 처리

- 워크플로우 오케스트레이션: 여러 AI의 실행 순서와 조건을 제어하여 하나의 목적 달성

2. MCP: 도구와 데이터 연결의 표준

MCP는 LLM이 외부 데이터, 도구, 애플리케이션 등과 표준화된 방식으로 실시간 상호작용할 수 있도록 설계된 개방형 프로토콜입니다.

MCP의 핵심 목표는 모델이 외부 시스템과 쉽게 연결되어, 정보를 불러오거나 기능을 실행할 수 있도록 하는 것입니다.

- 언어 모델에게 정보를 기억하고, 이해하고, 활용하게 하는 방법

- 정보를 어떻게 주고받을 것인가에 대한 약속된 표준 포맷

- 즉, “GPT에게 정보를 주고, 다시 받을 때 어떤 형태로 정리할까?”에 대한 통신 규약

3. MCP와 A2A의 차이

| 항목 | MCP | A2A |

|---|---|---|

| 개념 | LLM이 외부와 상호작용할 때 사용하는 문맥∙데이터 교환 포맷 | 하나의 AI 에이전트가 다른 에이전트와 대화하거나 협업하는 방식 |

| 목적 | 문맥(Context)을 구조화해서 모델에 주입 | 에이전트들 간에 역할 분담, 정보 전달, 작업 위임 |

| 역할 | JSON 형식으로 사용자 상태, 기억, 요청 등을 전달 | AI끼리의 커뮤니케이션 및 워크플로우 실행 방식 |

| 관계 | A2A 통신에서도 데이터 형식으로 재사용 가능 | MCP를 내포 혹은 확장해 에이전트 간 교환 데이터로 사용 가능 |

| 예시 | User: “내 생일은 5월 3일이야” → Context에 저장 → 추후 맞춤 알림‧추천에 활용 | Search Agent: “이 기사 찾아줘” → Summarizer Agent가 결과 요약 후 사용자에게 응답 |

4. Hands-on: 뉴스 요약 A2A 시나리오 구현

Python과 LangChain을 활용해 간단한 A2A 구조를 직접 구현해보겠습니다. A2A 구조는 여러 개의 에이전트가 역할을 나누어 순차적으로 작업을 수행하는 방식입니다.

시나리오

“검색 에이전트가 뉴스 요약 에이전트에게 데이터를 전달하고, 요약된 결과를 사용자가 받아본다.”

아키텍처

두 개의 LangChain 기반 에이전트가 협업하는 구조입니다.

SearchNews: 특정 주제의 뉴스를 수집하는 에이전트SummarizeNews: 수집한 뉴스를 요약하는 에이전트

[User Query]

|

V

[SearchNews Agent] → 뉴스 수집

|

V

(뉴스 결과 텍스트)

|

V

[SummarizeNews Agent] → 요약 처리

|

V

(요약문)

|

V

[최종 응답]

요구사항

| 패키지명 | 설명 |

|---|---|

langchain | 에이전트 오케스트레이션 및 구성 지원 |

openai | OpenAI GPT 모델 연결용 공식 API 패키지 |

python-dotenv | .env 환경변수 파일 로드용 유틸리티 |

검색 에이전트 (agent_search)

사용자의 질의를 받아 DuckDuckGo를 통해 관련 뉴스를 검색합니다.

최신 뉴스 3건의 제목, 요약, 링크를 텍스트로 반환합니다.

from langchain_community.tools import DuckDuckGoSearchRun

# LangChain Tool 객체 → main.py에서 바로 사용

search_tool = DuckDuckGoSearchRun(

name="SearchNews",

description="특정 주제의 최신 뉴스를 검색한다"

)요약 에이전트 (agent_summary)

전달받은 뉴스 텍스트를 GPT-4o-mini를 이용해 3문장 이내의 요약문으로 정리합니다.

from langchain.chat_models import ChatOpenAI

from langchain.agents import Tool

def build_summary_tool(llm):

"""LLM을 주입받아 요약 Tool 생성"""

def _summarize(text: str, *_, **__) -> str:

prompt = f"다음 뉴스를 한국어로 3문장 이내로 요약해줘:\n{text}"

return llm.invoke(prompt)

return Tool(

name="SummarizeNews",

func=_summarize,

description="뉴스 콘텐츠를 간결하게 요약한다"

)오케스트레이터

정의한 두 에이전트(Search, Summarize)를 tools로 등록하고, LLM과 함께 사용하여 사용자의 질의에 따라 필요한 순서로 실행합니다.verbose=True로 실행하면 프롬프트 → Thought → Action → Observation → Final Answer의 전체 흐름을 로그로 확인할 수 있어, 오케스트레이션 동작을 쉽게 파악할 수 있습니다.

from dotenv import load_dotenv

from langchain_openai import ChatOpenAI

from langchain.agents import initialize_agent, AgentType

from agent_search import search_tool

from agent_summary import build_summary_tool

load_dotenv()

# 1) LLM 설정

llm = ChatOpenAI(

model="gpt-4o-mini",

temperature=0.3

)

summary_tool = build_summary_tool(llm)

# 2) 전체 도구 리스트

tools = [search_tool, summary_tool]

# 3) 에이전트 초기화

agent_executor = initialize_agent(

tools=tools,

llm=llm,

agent=AgentType.ZERO_SHOT_REACT_DESCRIPTION,

verbose=True # 프롬프트·Thought·Action·Observation 로그 확인용

)

if __name__ == "__main__":

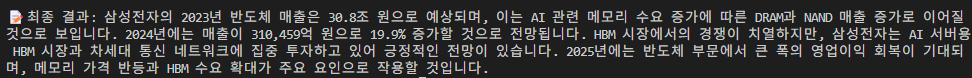

query = "삼성전자 반도체 매출 전망을 찾아서 요약해 줘"

result = agent_executor.run(query)

print("\n 최종 결과:", result)결과

실행 결과, 사용자의 질의에 따라 검색 → 요약 → 응답까지 단계별로 자동 처리되는 것을 확인할 수 있습니다.

이처럼 A2A 구조와 오케스트레이터를 활용하면, 복잡한 멀티에이전트 워크플로우도 쉽게 구현할 수 있습니다.

5. 적용 사례와 미래 전망

- 테슬라(Tesla): AI 에이전트가 자율주행 시스템에서 도로 데이터를 실시간으로 분석해 운전 작업 수행.

- JP모건(JP Morgan): AI 에이전트가 자동화된 금융 트레이딩 시스템에서 실시간 시장 데이터 분석 및 매매 실행.

- 삼성SDS: ‘브리티 코파일럿’ 퍼스널 에이전트가 보험 처리 시간을 단축.

- 한국딥러닝: 법인등기부등본 자동화 AI 문서 에이전트 체계 구축.

- 구글, 마이크로소프트, 삼성전자 등: 고객 응대, 일정 관리, 업무 자동화 등 다양한 분야에서 AI 에이전트 활용.

전세계 AI 에이전트 시장은 2024년 약 51억 달러(약 7조 원)에서 2030년에는 471~503억 달러(약 67~72조 원)로 9배 이상 성장할 것으로 전망됩니다.

A2A는 에이전트 간 협업을 표준화하고 MCP는 외부 시스템과의 연동을 지원해 함께 사용할 때 AI 에이전트 생태계의 상호운용성과 확장성이 극대화됩니다. 두 프로토콜은 AI 에이전트 시장의 양대 축으로 자리매김하며, 산업 전반의 업무 자동화와 혁신을 이끌 것으로 보입니다.

결론

“A2A는 에이전트 협업의 플랫폼, MCP는 도구 연결의 브릿지. 두 프로토콜이 만나 AI 오케스트레이션의 미래를 연다.”

LLM 이후, AI는 단일 모델 중심에서 벗어나 멀티에이전트 협업과 오케스트레이션의 시대로 진입하고 있습니다.

A2A 프로토콜은 여러 에이전트가 유기적으로 협업하며 복잡한 업무를 자동화하는 데 핵심적인 역할을 하며 MCP는 AI가 외부 도구와 데이터에 접근할 수 있도록 표준화된 인터페이스를 제공합니다.

이 두 프로토콜은 각각의 영역에서 AI 생태계의 확장성과 상호운용성을 높여주며 함께 사용할 때 더욱 강력한 AI 오케스트레이션 시스템을 실현할 수 있습니다.

앞으로 AI 시스템은 단일 모델 중심에서 벗어나, A2A와 MCP가 조화를 이루는 멀티에이전트 오케스트레이션 구조로 진화할 것입니다.

REFERENCES

- Google 공식 A2A 프로토콜 문서:

https://google.github.io/A2A/#/ - Google Developers 블로그 – A2A 소개:

https://developers.googleblog.com/ko/a2a-a-new-era-of-agent-interoperability/ - Logto 블로그 – A2A vs MCP:

https://blog.logto.io/ko/a2a-mcp